IT之家 2 月 13 日消息,英伟达昨日(2 月 12 日)发布博文,宣布在 AI 推理领域的“token 经济学”(Tokenomics)方面,其 Blackwell 架构取得里程碑式进展。

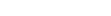

英伟达在博文中指出,通过推行“极致软硬件协同设计”策略,优化硬件在处理复杂 AI 推理负载时的效率,解决了随着模型参数膨胀带来的算力成本激增问题。数据显示相比上一代 Hopper 架构,Blackwell 平台将单位 Token 生成成本降低至十分之一。

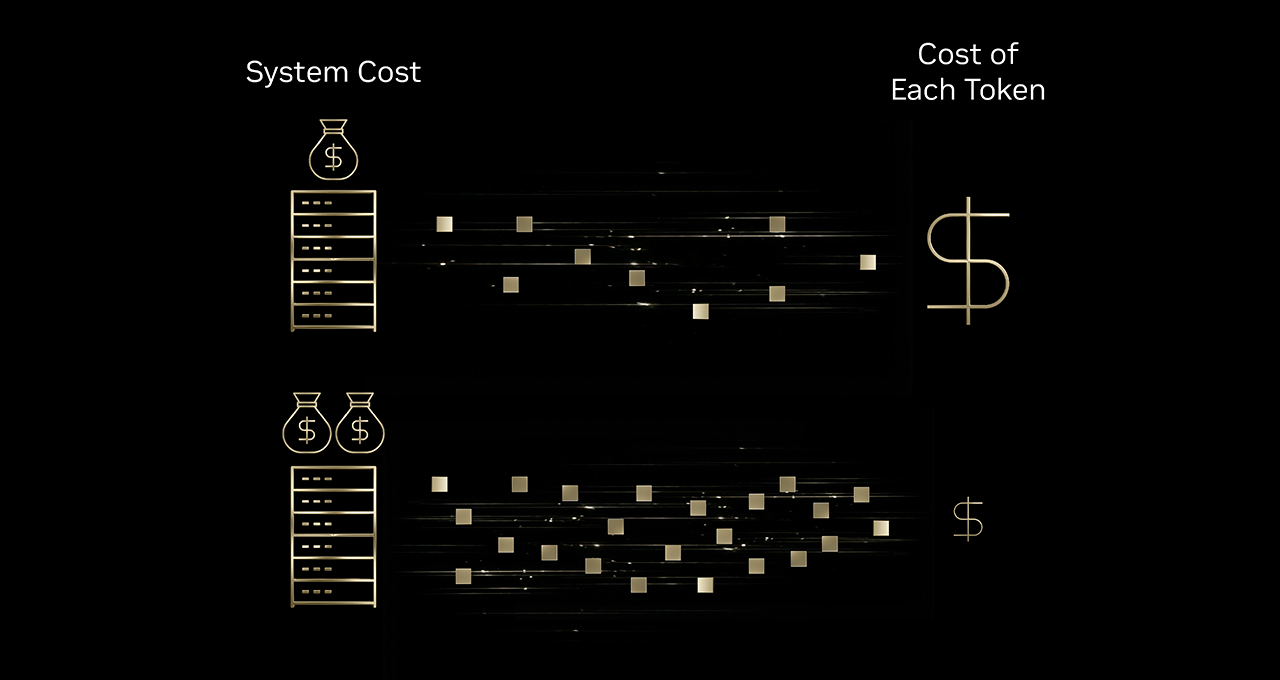

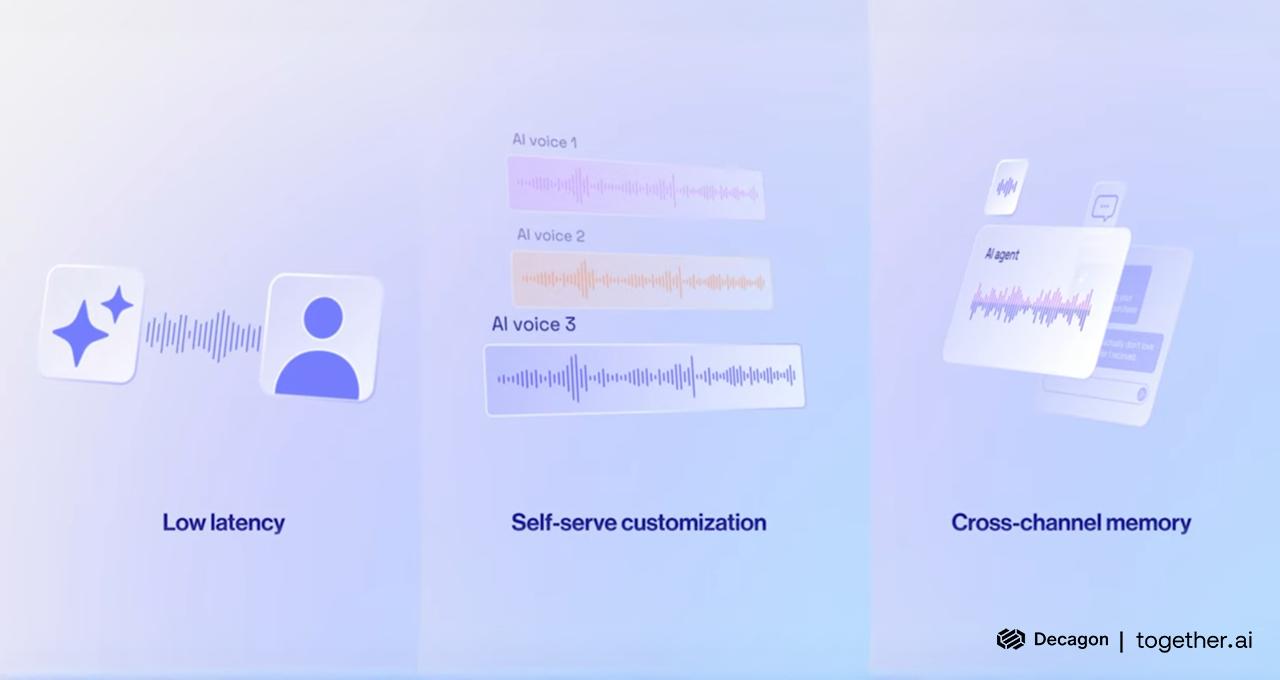

行业落地方面,包括 Baseten、DeepInfra、Fireworks AI 及 Together AI 在内的多家推理服务提供商已开始利用 Blackwell 平台托管开源模型。

IT之家援引博文介绍,英伟达指出,通过结合开源前沿智能模型、Blackwell 的硬件优势以及各厂商自研的优化推理栈,这些企业成功实现了跨行业的成本缩减。

例如,专注于多智能体(Multi-agent)工作流的 Sentient Labs 反馈,其成本效率相比 Hopper 时代提升了 25% 至 50%;而游戏领域的 Latitude 等公司也借此实现了更低的延迟和更可靠的响应。

Blackwell 的高效能核心在于其旗舰级系统 GB200 NVL72。该系统采用 72 个芯片互联的配置,并配备了高达 30TB 的高速共享内存。这种设计完美契合了当前主流的“混合专家(MoE)”架构需求,能够将 Token 批次高效地拆分并分散到各个 GPU 上并行处理。

在 Blackwell 大获成功的同时,英伟达已将目光投向下一代代号为“Vera Rubin”的平台。据悉,Rubin 架构计划通过引入针对预填充(Prefill)阶段的 CPX 等专用机制,进一步推高基础设施的效率天花板。