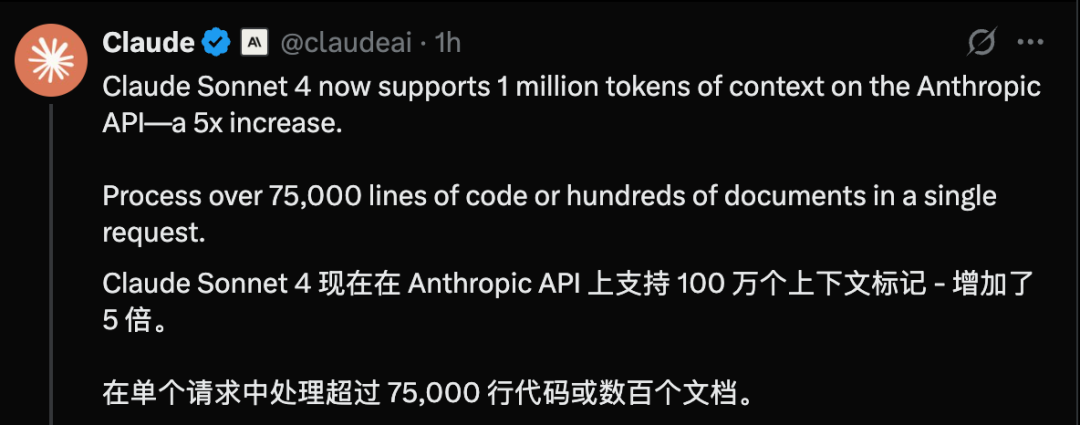

Anthropic刚刚宣布Claude Sonnet 4现已支持高达100万Token的上下文窗口,容量是之前的5倍,开发者在单次请求中就能处理整个大型代码库(超过75,000行代码)或数十篇研究论文

Sonnet 4的长上下文支持目前已在Anthropic API上向Tier 4和拥有自定义速率限制的客户开放公测,并将在未来几周内向更广泛的用户推出

详细信息:

https://docs.anthropic.com/en/docs/build-with-claude/context-windows#1m-token-context-window

目前,Sonnet 4的长上下文功能已在亚马逊Bedrock上作为公开测试版(public beta)提供,此外,该功能也即将登陆Google Cloud的Vertex AI平台

用例

100万Token的上下文窗口意味着Claude能够处理和理解前所未有的信息量,从而支持更全面、数据更密集的复杂任务。开发者现在可以利用Claude实现以下高级用例:

大规模代码分析: 将包含源文件、测试和文档的完整代码库一次性加载给Claude。模型能够深入理解项目架构,识别跨文件的依赖关系,并为整个系统的设计提出优化建议

海量文档合成: 处理如法律合同、学术研究论文集或技术规范等大量文档。Claude可以在保持完整上下文的情况下,分析数百份文档之间的复杂关系

上下文感知智能体(Agent): 构建能够在数百次工具调用和多步骤工作流中保持上下文的智能体。开发者可以向其提供完整的API文档、工具定义和交互历史,而无需担心模型遗忘关键信息,从而保证了智能体行为的连贯性

全新定价模型与成本优化方案

为了应对处理超长上下文所需增加的计算资源,Anthropic为超过200K Token的提示(prompt)调整了定价。具体的定价结构如下:

提示长度 |

输入价格 (每百万Token) |

输出价格 (每百万Token) |

|---|---|---|

| ≤ 200K Tokens | $3 |

$15 |

| > 200K Tokens | $6 |

$22.50 |

Anthropic同时指出,开发者可以通过结合使用提示缓存(prompt caching)来降低长上下文应用的延迟和成本。此外,利用批处理(batch processing)功能处理100万Token上下文的任务,还可额外节省50%的成本

价格:

https://www.anthropic.com/pricing#api

早期用户好评如潮:解锁生产级AI工程

此次更新已获得早期合作伙伴的高度评价:金杯银杯不如用户的口碑

Bolt.new,一家将Claude集成到其浏览器开发平台的公司,其联合创始人兼CEO Eric Simons表示:“Claude Sonnet 4一直是他们代码生成工作流的首选模型,其性能在生产环境中持续优于其他领先模型。现在有了100万Token的上下文窗口,开发者可以在处理真实世界的大型项目时,依然保持所需的高准确性

iGent AI,一家总部位于伦敦、专注于将对话转化为可执行代码的软件开发公司,其联合创始人兼CEO Sean Ward也分享:曾经的不可能,如今已成现实。拥有100万Token上下文的Claude Sonnet 4极大地增强了软件工程智能体Maestro的自主能力。这一飞跃解锁了真正的生产级工程——能够在真实世界的代码库上进行持续数天的开发会话,从而在智能体软件工程领域建立了一个新的范式

参考:

https://www.anthropic.com/news/1m-context