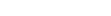

见证历史!

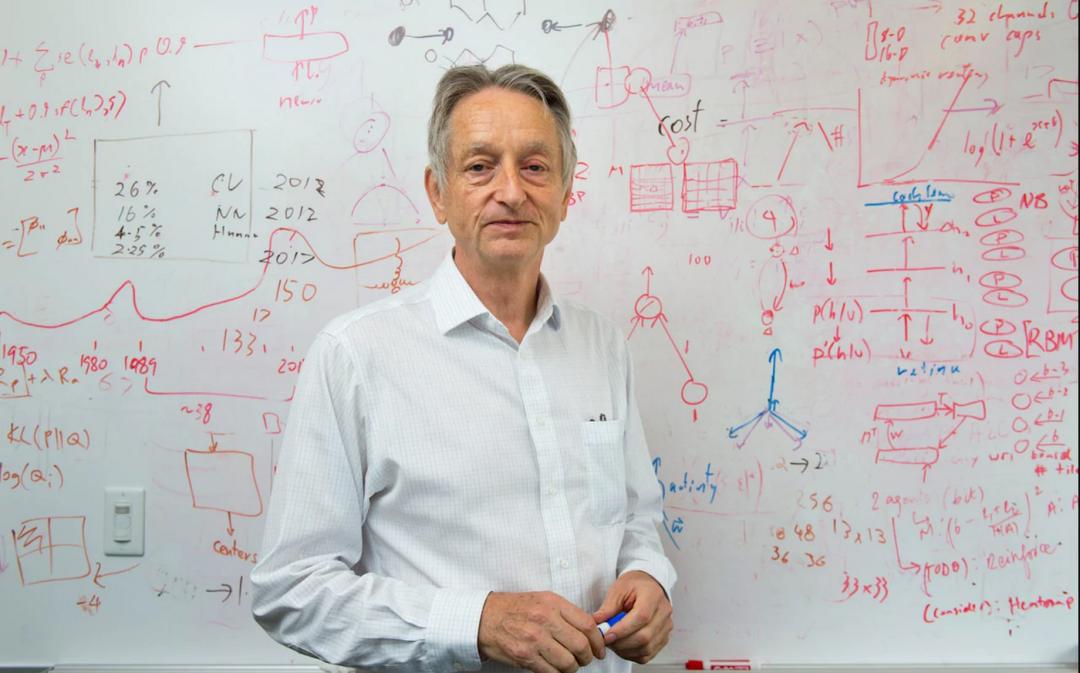

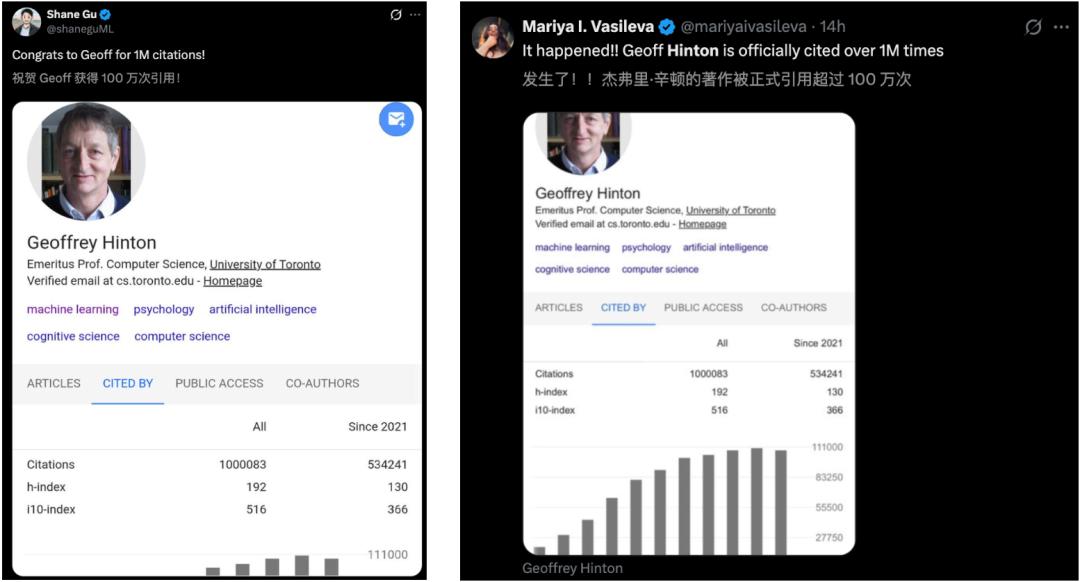

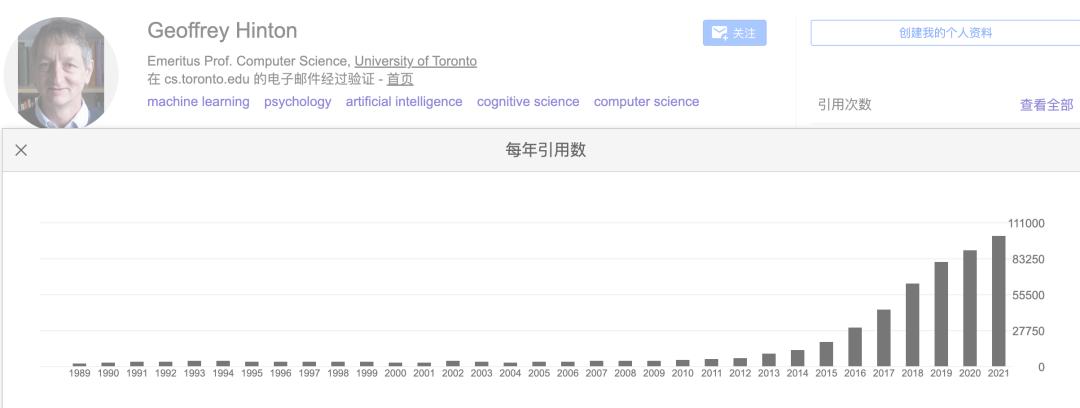

刚刚,AI教父、图灵奖巨头Geoffrey Hinton论文被引数正式破100万!

他是继Yoshua Bengio之后,全球第二位论文引用量突破百万的学者。

学术地位无可撼动!

一时间,学术界的大牛们,纷纷为 Hinton送上了祝贺。

百万被引,世界第二人

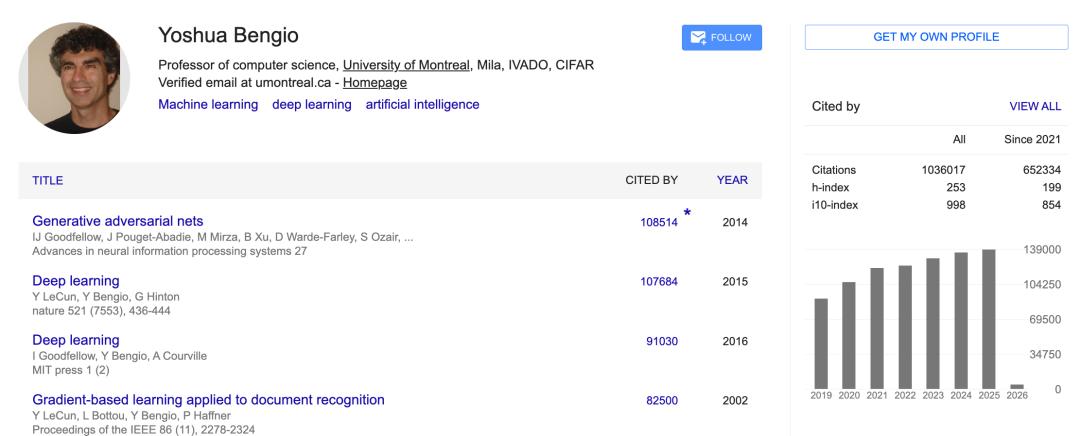

两个月前,Nature曾发文:Bengio成为世界首位被引数超100万的研究者。

这一纪录被很多人视作AI时代的学术注脚。

目前,谷歌学术显示,Bengio被引次数已达到103.6万!

如今,Hinton被引数迅速突破百万门槛,更像是同一条浪潮的回声:

深度学习的核心理论与方法,正在被前所未有的研究规模「持续引用、持续放大」。

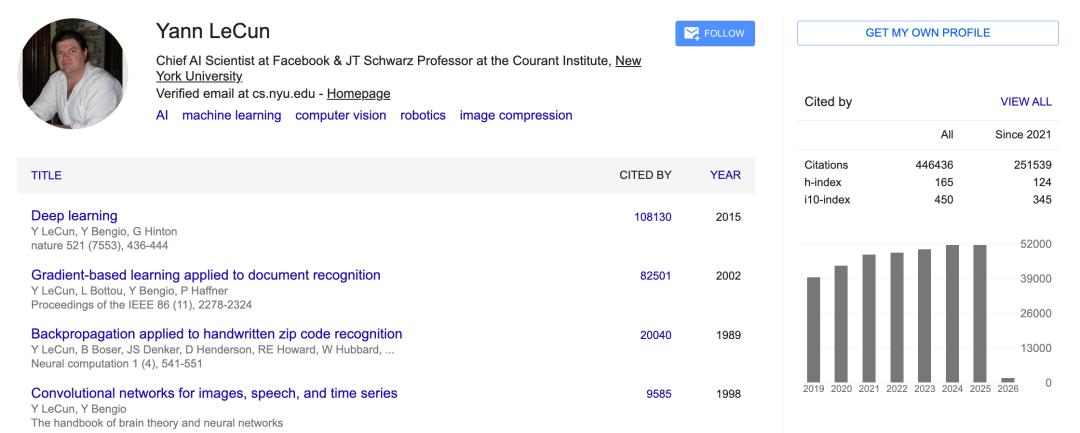

不仅如此,同为图灵奖三巨头的Yann LeCun的被引数也达到了恐怖的45万级。

传奇仍在续写

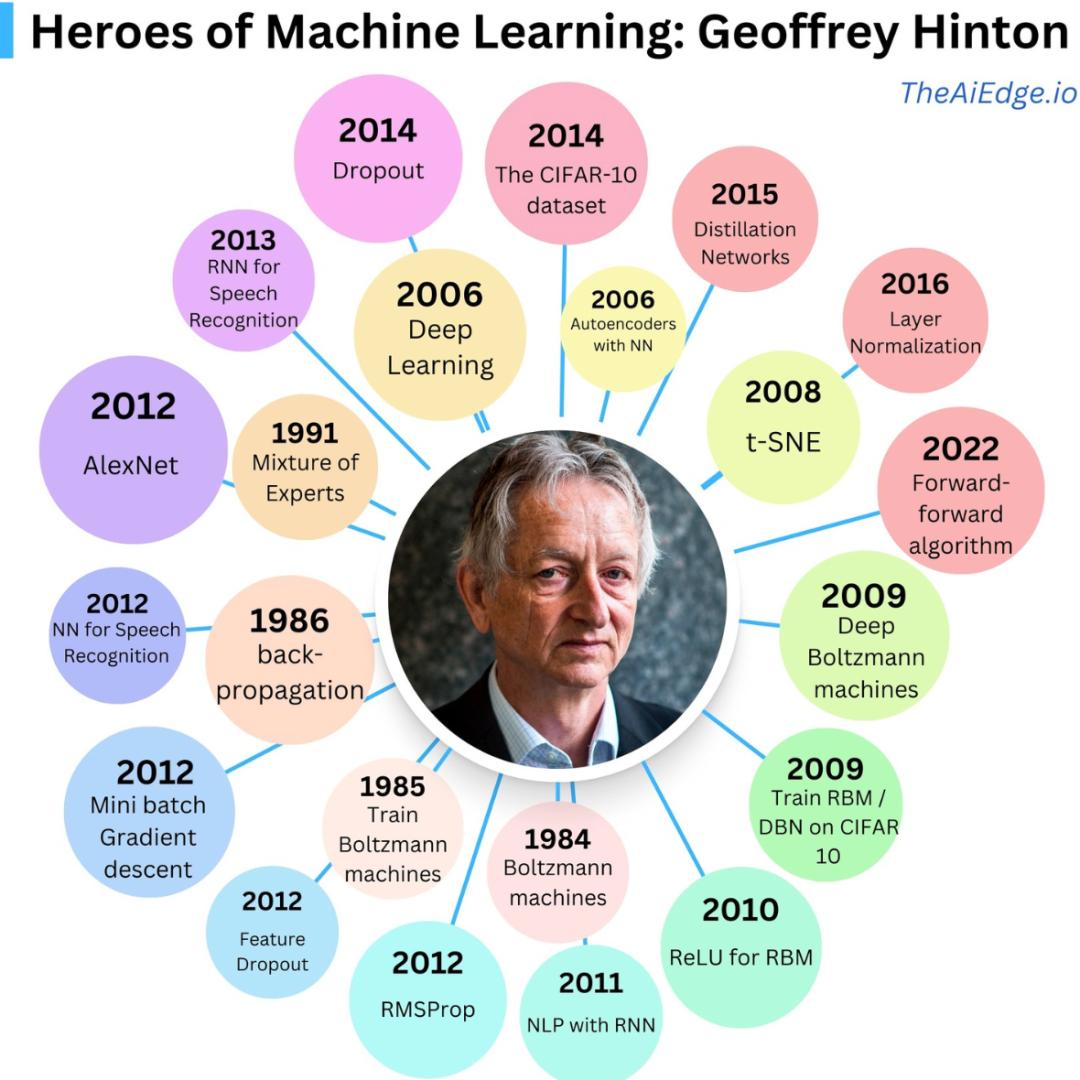

这一成就,植根于Hinton数十年来持续不断的学术积淀。

可以说,读懂他的全部研究,相当于掌握了深度学习的发展脉络与演进史。

Hinton的代表作列表,会有一种强烈的既视感,其中有几篇「时代级论文」的引用数格外醒目:

AlexNet(ImageNet 2012):18万+引用,深度学习大规模视觉突破的重要标志

AlexNet让神经网络第一次以压倒性优势赢下大规模视觉竞赛,直接点燃了深度学习在工业界的信心。

更重要的是,它把「数据+GPU+端到端训练」的路线写成了可复用的范式,从此视觉、语音、推荐都开始沿着同一套工程逻辑加速迭代。

Deep Learning(Nature 2015):10万+引用,三巨头合著,成为无数论文的共同起点

Deep Learning更像一本「统一语言的说明书」,把分散在不同子领域的研究线索串成框架:

神经网络为什么能学、怎么训练、能解决什么问题、还缺什么关键环节。

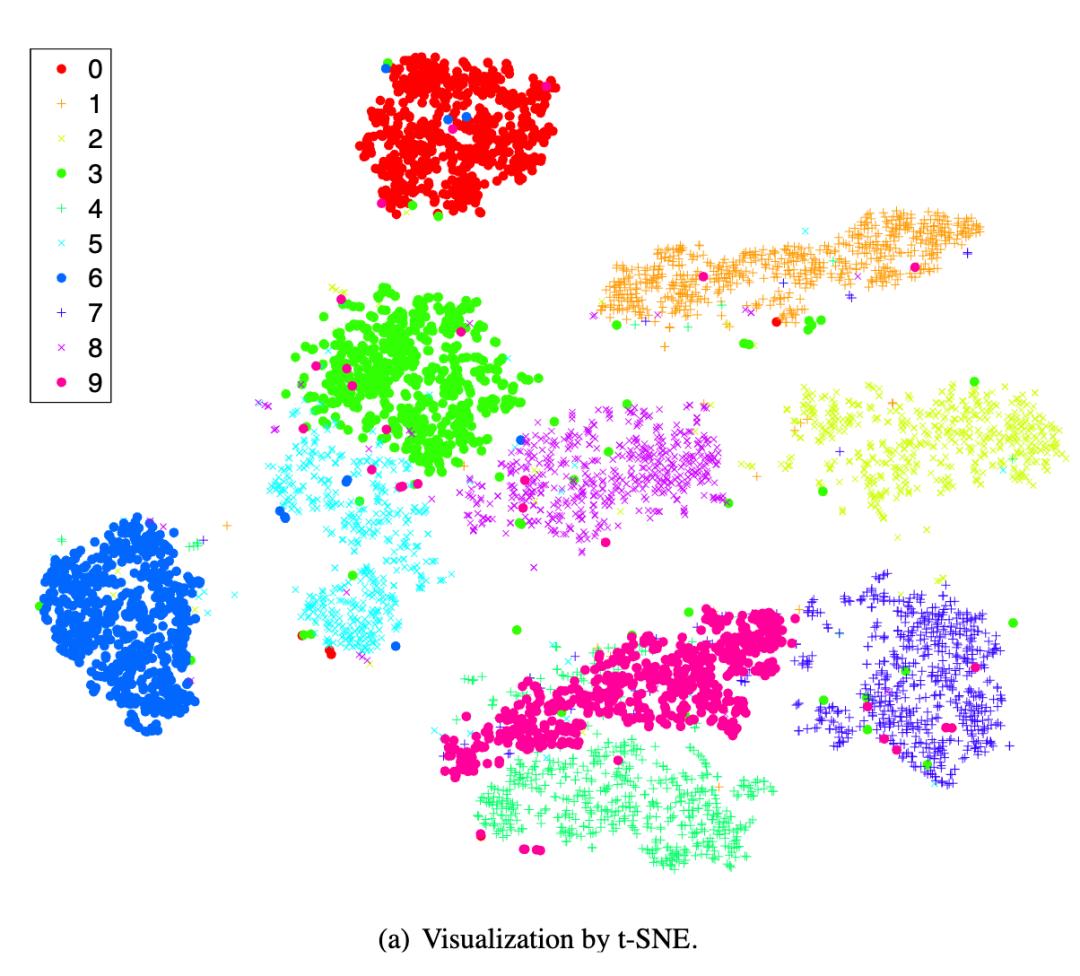

t-SNE可视化(2008):6万+引用,直到今天仍是科研可视化的常用工具

t-SNE改变了研究者理解模型的方式,比如高维特征怎么分簇、类别边界怎么形成、错误样本为什么混在一起。

它把这些「黑箱内部的形状」变成可直观看到的图像。

Dropout(2014):6万+引用,训练神经网络时的「基础操作」

Dropout把「泛化」这件事从玄学变成了操作:训练时随机丢弃部分神经元,逼着网络学到更稳健的表示,减少过拟合。

甚至,很多人第一次接触深度学习的训练技巧,学到的就是它。

这些高被引论文覆盖了从理论到技巧、从模型到工具的多个层面:它们不只提供答案,还定义了「怎么提问、怎么验证、怎么训练、怎么呈现」。

在AI浪潮中,Hinton的早期贡献如今支撑着ChatGPT、Gemini等大模型的运行。

Bengio作为首位破百万者,开启了这一时代;Hinton的加入,进一步巩固了深度学习在学术界的霸主地位。

最近,Hinton还在一期演讲中表示,大模型(LLM)的运作宛如人脑,是一个通过数据自我演化的「黑箱」。

其智能源于从数据中学习,并调整数万亿连接的强度。正因如此,其内部认知过程,在很大程度上仍是个谜。

因此,这一领域仍需未来的AI研究者们持续探索、不断突破。

学术经历

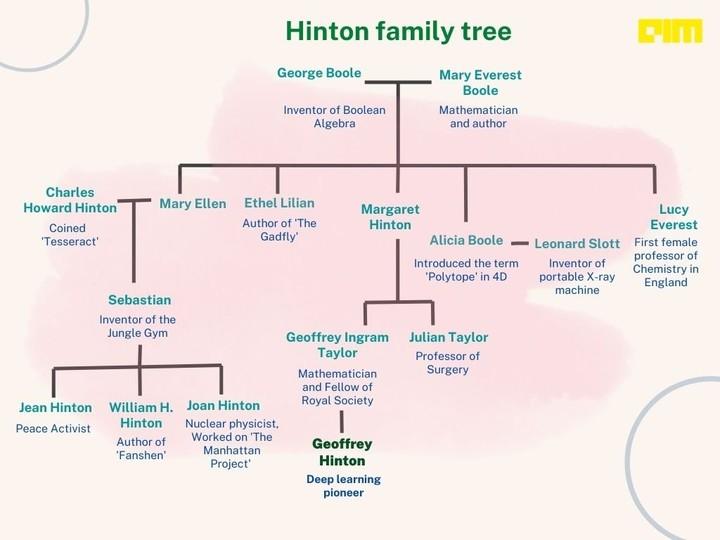

Hinton 1947年生于英国伦敦,出身学术世家,其曾曾祖父乔治·布尔,开发了二元推理系统「布尔代数」,构成了现代计算机的基础。

1970年,他从剑桥大学国王学院获实验心理学学士学位,后转攻计算机科学;1978年于爱丁堡大学获博士学位,师从Christopher Longuet-Higgins,博士论文聚焦于连接主义模型的语义学习。

职业生涯早期,Hinton在加州大学圣迭戈分校和卡内基梅隆大学任教,但因神经网络在当时被主流AI社区视为「死胡同」,他于1987年转至加拿大多伦多大学计算机科学系任教,直至2023年退休。

在多伦多,他组建了神经计算与自适应感知实验室(Neural Computation and Adaptive Perception Lab),培养了众多AI精英。

2013年起,他兼任谷歌脑(Google Brain)副总裁,推动工业级深度学习落地,如语音识别和图像分类。

Hinton的坚持源于对生物大脑启发的信念:在AI寒冬期,他通过反向传播(backpropagation)优化多层网络,并在2006年提出深度信念网络(Deep Belief Networks),利用无监督预训练解决梯度消失问题,最终引发深度学习复兴,催生了AlexNet等标志性突破。

2018年,Hinton与Yann LeCun和Yoshua Bengio共同获图灵奖,表彰他们在深度神经网络概念性及工程性突破方面的开创性贡献,特别是其工作奠定了现代AI的核心算法基础,使计算机能够从海量数据中自主学习复杂模式。

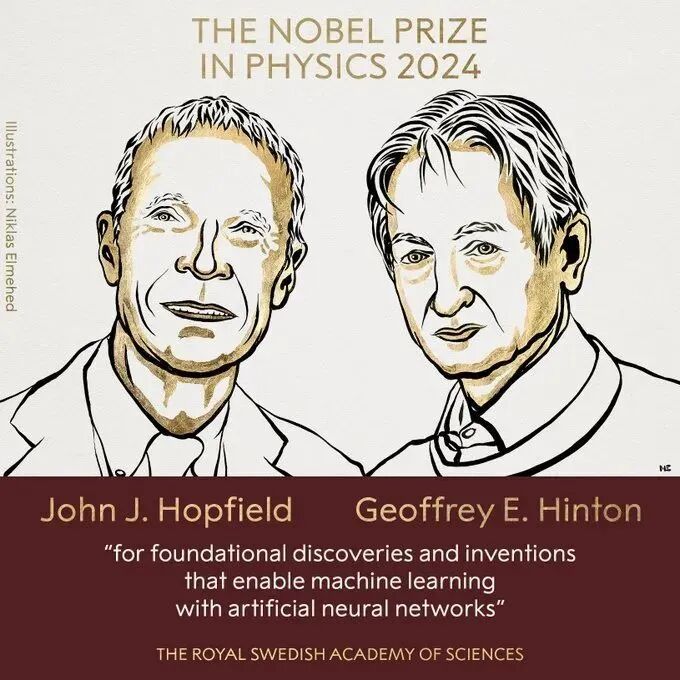

2024年,Hinton与约翰·霍普菲尔德(John Hopfield)共同获诺贝尔物理学奖,表彰他们在人工神经网络上的基础发现和发明,这些工作启用了机器学习技术,包括霍普菲尔德网络和玻尔兹曼机,也是诺贝尔物理学奖首次颁给非传统物理学家。

AlexNet开启深度学习时代

2009年,李飞飞启动ImageNet项目,提供大规模标注数据集,促进特征学习和分类研究。

在AlexNet提出前,计算机视觉主要依赖手工设计的特征(如SIFT、HOG),浅层机器学习模型难以处理ImageNet的1000万图像和1000类复杂任务,导致错误率停留在25%-30%(Top-5)。

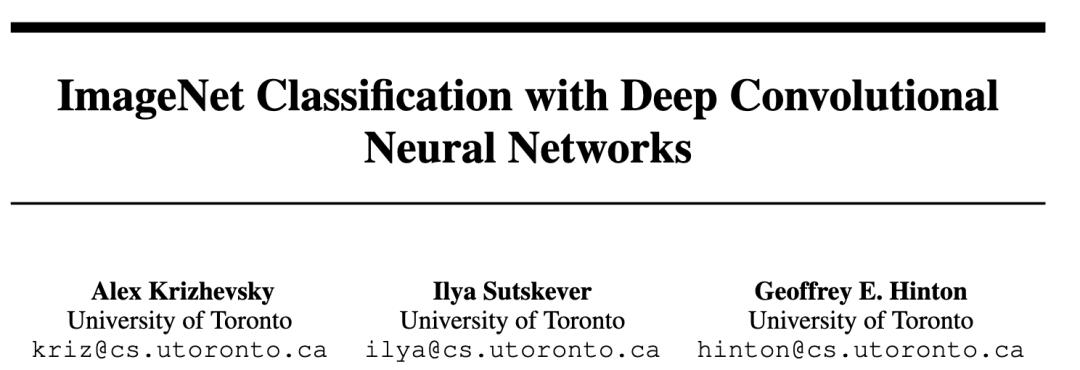

2012年,Alex Krizhevsky、Ilya Sutskever和Geoffrey Hinton于2012年发表在NeurIPS会议,提出了一种大型深度卷积神经网络(CNN)AlexNet,用于ImageNet LSVRC-2010竞赛的图像分类任务。

论文链接:https://proceedings.neurips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

引用次数:188837

虽然深度神经网络也曾流行于90年代,但因计算资源不足、梯度消失和过拟合而衰退。

随着GPU计算能力的提升(如NVIDIA CUDA),为训练大型网络提供了硬件基础,AlexNet借此成功证明深度CNN在海量数据和强大硬件支持下可实现突破,结束了「特征工程」时代,开启深度学习复兴。

AlexNet网络包含8层(5个卷积层+3个全连接层),拥有6000万个参数和65万个神经元,使用ReLU激活函数、非饱和神经元、Dropout正则化、数据增强和多GPU训练等创新技术。

在测试集上,Top-1错误率37.5%、Top-5错误率17.0%,大幅优于当时最先进方法;在ILSVRC-2012竞赛中,Top-5错误率仅15.3%,远超第二名26.2%。

这篇论文标志着深度学习革命的开端,推动CNN成为计算机视觉主流,推动了从手工艺特征向端到端学习的转变。

AlexNet架构启发了VGG、ResNet等后续模型,广泛应用于目标检测、分割和生成等领域,并促进了GPU加速和大规模数据集的使用,重塑AI研究格局。

三巨头合著

到了2015年,虽然深度学习已经在学术界引起轰动,但在更广泛的科学领域(如《Nature》的读者群体),大家仍对其背后的原理、潜力以及它与传统机器学习的区别缺乏系统认知。

在人工智能「大爆发」的前夜,由三巨头联合发表于Nature,向全世界科学界系统性地定义了什么是「深度学习」。

论文链接:https://www.nature.com/articles/nature14539

引用次数:107646

文章深入浅出地解释了深度学习区别于传统方法的关键点:

表征学习 (Representation Learning):深度学习的核心是自动学习特征,通过多个处理层,将原始数据(如像素点)转化为更高层次、更抽象的表达。

反向传播算法 (Backpropagation):论文详细描述了系统如何通过计算误差梯度,从输出层向输入层反推,更新每一层神经元之间的权重(Parameters),从而实现学习。

核心架构:卷积神经网络 (CNN)专门用于处理具有空间结构的数据(如图像、视频),利用了自然图像的统计特性(局部相关性和平移不变性);循环神经网络 (RNN):专门用于处理序列数据(如文本、语音),能够处理变长的输入流。

这篇文章总结了过去三十年的探索,并开启了我们现在所处的「大模型时代」。

t-SNE特征可视化

t-SNE(t-distributed Stochastic Neighbor Embedding)论文发表于2008年,解决了数据科学领域一个核心痛点:如何让昂贵、复杂的高维数据变得肉眼可见?

在此前,研究人员主要使用主成分分析(PCA)或传统的随机邻域嵌入(SNE)来降维,但PCA在处理非线性数据(如流形结构)时效果很差,SNE在将高维空间的数据映射到低维(2D/3D)时,空间会变得极其拥挤,导致不同类别的簇混在一起,无法分辨。

论文链接:http://www.jmlr.org/papers/volume9/vandermaaten08a/vandermaaten08a.pdf

引用次数:63932

t-SNE的做法是:在高维空间中使用高斯分布来衡量点与点之间的相似度。如果两个点离得近,它们被选为邻居的概率就高;在低维空间中,改用 Student t-分布(自由度为 1)而非高斯分布来衡量相似度,因为t分布的尾部比高斯分布更「胖」,强制让原本在低维空间中距离较远的点被推得更远,从而有效地解决了「拥挤问题」,让不同的数据簇(Cluster)在视觉上分界非常明显。

t-SNE发表后,迅速成为高维数据可视化的行业标准,常见的场景包括观察模型隐藏层提取的特征(MNIST手写数字自动聚成不同的团),在单细胞测序中识别新的细胞种类等。

不过t-SNE也有一些局限性,如计算量大,处理超大规模数据集时速度较慢(后来有了FIt-SNE等加速版本);虽然保证了局部结构,但簇与簇之间的远近距离并不一定代表真实的全局差异;算法对超参数敏感,需要多次调试。

正则化神器DropOut

论文链接:https://dl.acm.org/doi/abs/10.5555/2627435.2670313

引用数:60895

2014年,深度神经网络由于强大的建模能力而初显锋芒、但同时也深受「过拟合(Overfitting)」困扰。随着网络层数和参数量的剧增,模型极其容易对训练数据产生「死记硬背」的倾向,导致在面对未知数据时泛化性能极差。

虽然此前已有如权重衰减(Weight Decay)等正则化手段,但它们在处理超大规模网络时往往力不从心。

此外,虽然集成学习(Ensemble Learning,融合多个不同模型的预测结果)能有效缓解过拟合,但对于动辄数百万甚至数千万参数的神经网络而言,无论是在训练阶段维护多个大型模型,还是在测试阶段进行多次前向传播,其计算成本都高得令人难以接受。

论文提出了一个非常简单的机制Dropout(随机失活):在训练过程中,算法会根据预设的概率(通常为 0.5)随机地将隐含层单元的输出设为零,使其暂时「消失」在网络中,强迫每一个神经元都不能依赖于特定其他神经元的辅助,有效地打破了神经元之间的共适应性(Co-adaptation),使得每一个特征检测器必须变得更加独立且具有鲁棒性。

从数学视角看,Dropout 在训练时实际上是从指数级数量的「瘦身」网络中采样,而在测试阶段,研究者巧妙地通过使用包含全部神经元的完整网络,并按比例缩减权重,从而以极低的计算代价实现了对海量子网络预测结果的近似平均(Model Averaging)。

Dropout不仅使卷积神经网络(CNN)在计算机视觉任务(如 ImageNet 竞赛)中屡创佳绩,也成为了深度学习标准工具箱中不可或缺的正则化利器,也证明了通过主动引入「噪声」和「不确定性」反而能得到更稳定的特征表达。

虽然在近些年的发展中,诸如批归一化(Batch Normalization)等新技术在某些场景下部分替代了 Dropout 的功能,但其背后蕴含的集成学习思想和预防过拟合的哲学,依然是现代神经网络设计及优化理论的重要基石。

再次祝贺Hinton,向所有度过AI寒冬,仍然坚守AI的学者致敬!

参考资料:https://scholar.google.com/citations?user=JicYPdAAAAAJ